Einführung

Die Welt, in der wir leben, ist ein dreidimensionaler Raum, und das wichtigste Sinnesorgan des Menschen, die Augen, kann den Menschen nicht nur mit bunten Farbinformationen versorgen, sondern auch ein Gefühl der Distanz im Gehirn bilden, so dass wir eine dreidimensionale Welt wahrnehmen können. Seit der Geburt des ersten CCD-Bildsensors in den Bell Laboratories haben das maschinelle Sehen und die digitale Bildverarbeitungstechnologien in den letzten Jahrzehnten große Fortschritte gemacht und allen Lebensbereichen einen enormen Schub verliehen. Das Leben der Menschen, die industrielle Automatisierung, die Luft-und Raumfahrt und andere Bereiche haben begonnen, weithin mit Bild-und Vision-Technologie verbunden zu sein.

Von den Anfängen bis zum Wachstum im Bereich des maschinellen Sehens hat die 2D-Bildtechnologie mit Beibehaltung des Farbsehens als Einstiegspunkt die Entwicklungsprozesse von analog zu digital, von statisch zu dynamisch und von monochrom zu farbig erlebt. Die aktuelle 3D-Vision-Technologie besteht darin, dass Menschen, um die Dimension des maschinellen Sehens zu verbessern, stereoskopische Bilder vor ihren Augen präsentieren, die die Anwendungsszenarien erfüllen können, die in der Vergangenheit schwer von 2D-Vision zu erreichen waren, wie Face ID, Mobiltelefone, VR/AR, industrielle Vision und andere Richtungen, und eine neue visuelle Revolution in allen Lebensbereichen starten!

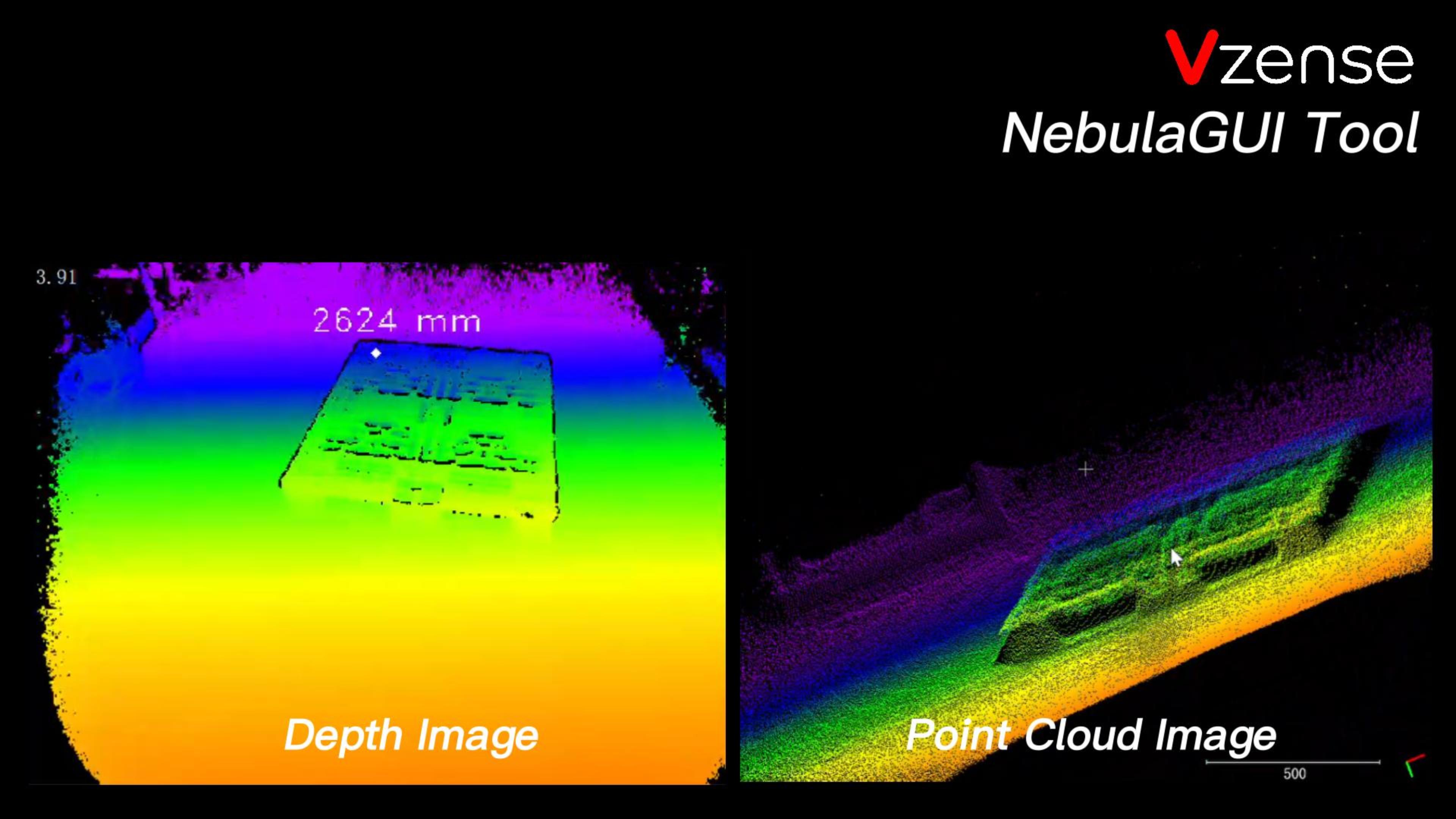

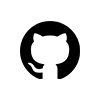

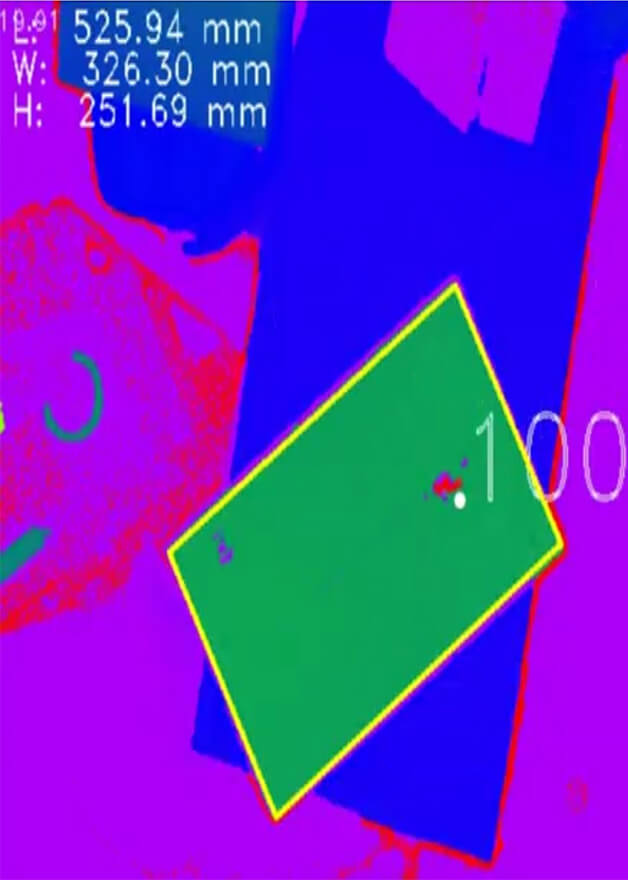

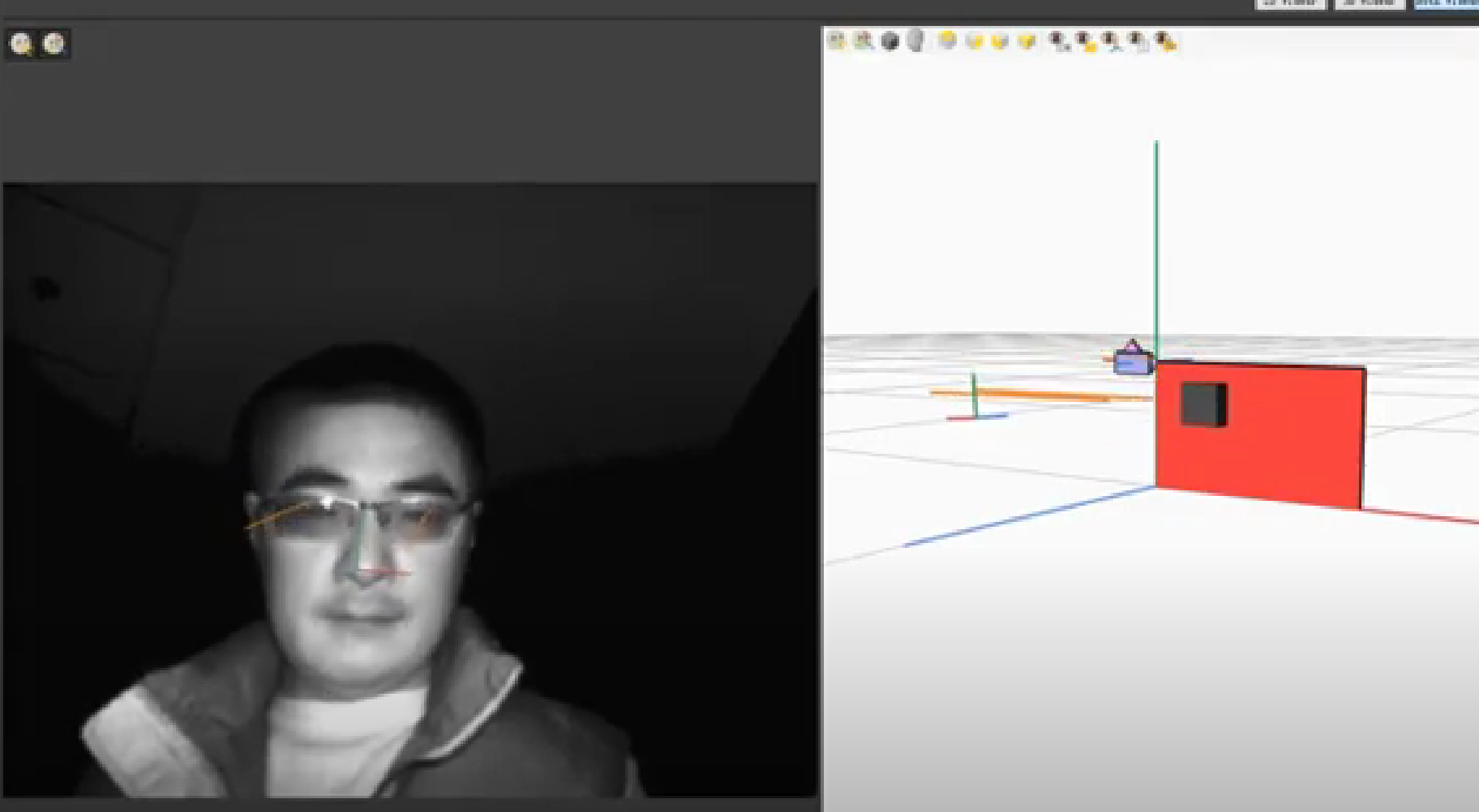

Wie in der obigen Abbildung gezeigt, besteht das von der Stereo-Vision-Technologie auf der rechten Seite angezeigte Bild im Gegensatz zu dem Bild, das von der herkömmlichen Farbkamera auf der linken Seite aufgenommen wurde, aus dem Entfernungswert von jedem Pixel zur Kamera. Um den Unterschied in der Entfernung besser darzustellen, werden normalerweise unterschiedliche Entfernungswerte auf dem Farbraum abgebildet, sodass Benutzer die Bedeutung des Tiefenbildes leichter verstehen können, wie in der folgenden Abbildung dargestellt:

Der Zweck und die Entwicklungsrichtung der 3D-Vision-Technologie besteht darin, genauere, exquisitere und schnellere Tiefenbilder durch verschiedene Methoden zu erhalten.

Taxonomie und Prinzipien der Entfernungsmessung

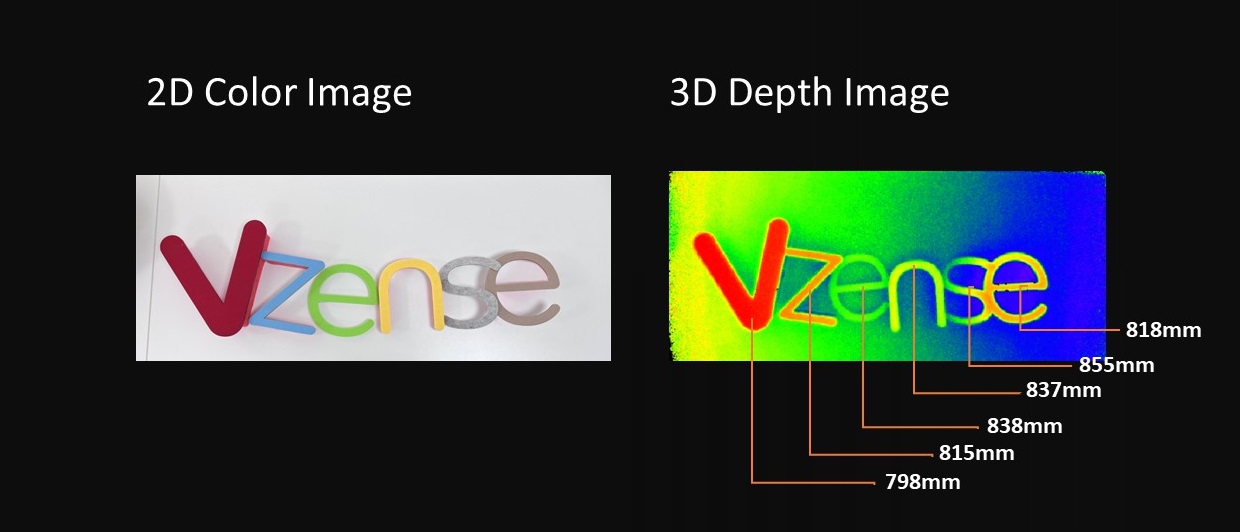

Die binokulare Vision-Technologie berechnet den Abstand zwischen dem Objekt und der Kamera durch Triangulation. Die Bildposition desselben Objekts in der linken und rechten Kamera ist unterschiedlich, und unterschiedliche Positionsunterschiede können in der Pixeldifferenz widergespiegelt werden, um die Entfernung zu berechnen. Die Technologie des strukturierten Lichtes ist eine aktive Stereo-Vision-Technologie. Der Laserprojektor projiziert Licht mit einer Form, und die Form wird deformiert, wenn sie auf das Objekt strahlt, und dann wird die Entfernung berechnet; Wir konzentrieren uns auf die ToF-Technologie (Time-of-Flight), was wörtlich Time-of-Flight-Technologie bedeutet, und im Großen und Ganzen gehören alle Time-of-Flight-Methoden zur Messung von Medien zur Kategorie der ToF-Technologien. Wenn Licht als Medium für die ToF-Messung verwendet wird, besteht das Prinzip darin, dass die Lichtquelle des ToF-Moduls Photonen an das gemessene Objekt emittiert und die zum ToF-Modul zurückreflektierte Photonen über den Bildsensor empfangen werden. Diese „Lichtlaufzeit“ wird gemessen. Die Entfernungsdaten werden unter der Prämisse erhalten, dass die Lichtgeschwindigkeit bekannt ist.

Die einfachste Ein-Pixel-ToF-Technologie verwendet einen modulierten Kollimationslaser als Sender, eine einzelne Fotodiode als Empfänger, die verwendet werden kann, um einen einzelnen Entfernungspunkt zu liefern. Wenn Sie erwarten, einen Ein-Pixel-Entfernungssensor zu verwenden, um ein Tiefenbild der gesamten Szene zu liefern, wird es im Allgemeinen eine Form des Scannens verwenden. Die Abbildung unten zeigt das Prinzip der Technologie der Ein-Pixel-ToF- Abstandsmessung.

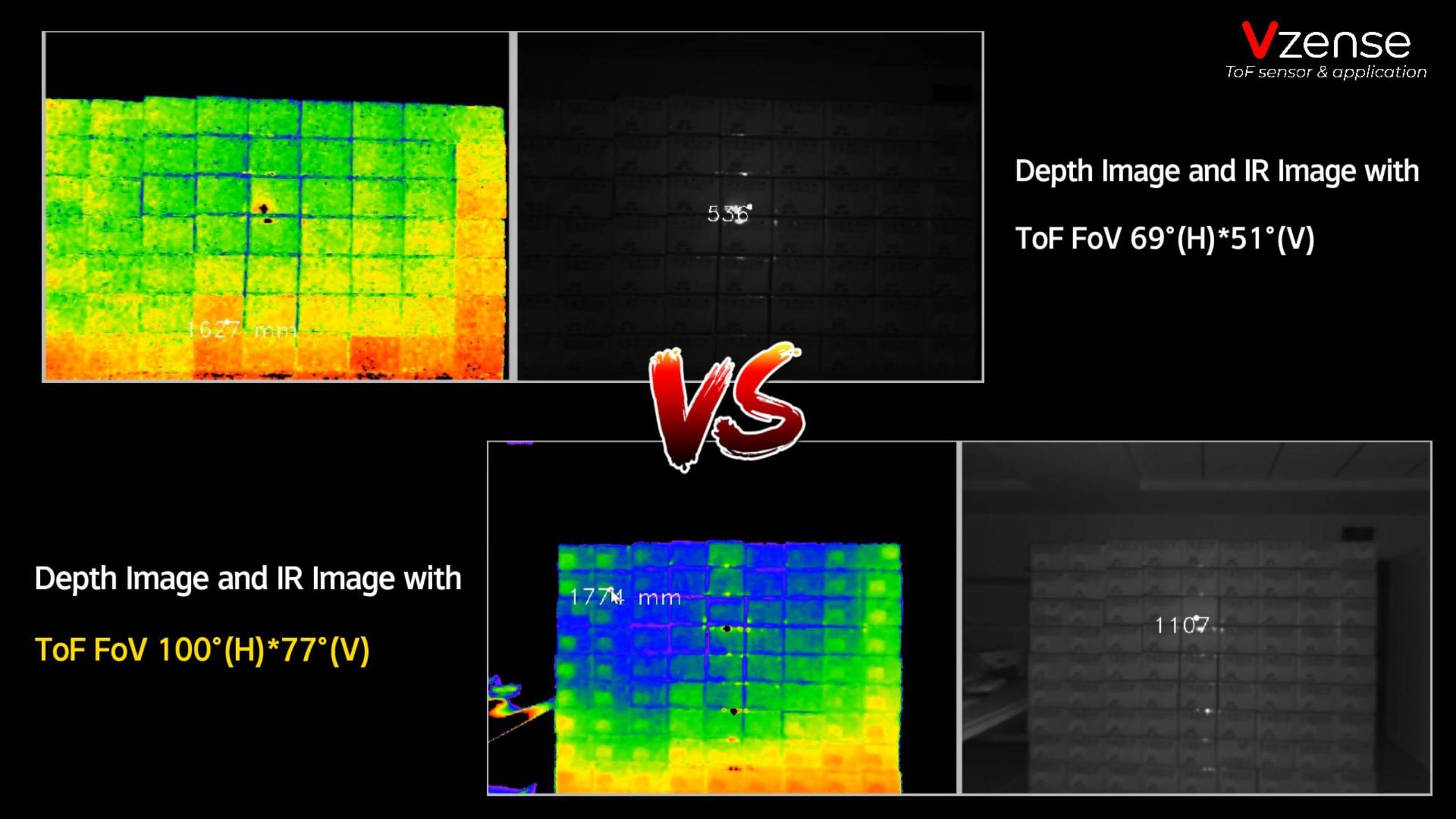

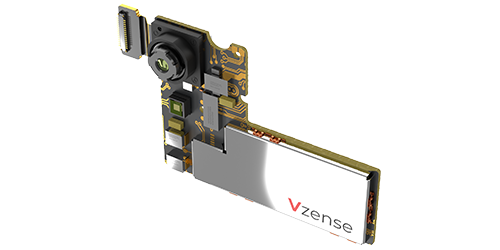

Die 3D-ToF-Technologie ist eine einmalige Bildgebung zur Bereitstellung eines vollständigen Szenentiefenbildes. Es gibt kein Scangerät. Mit der kontinuierlichen Reduzierung der Größe von Halbleiterkomponenten wurden kompakte und kostengünstige ToF-Tiefenkameras schnell im Bereich der Industrie- und Unterhaltungselektronik eingesetzt und entwickelt.

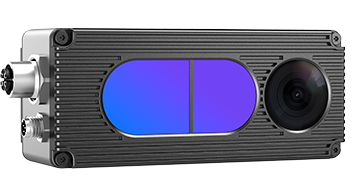

Komponenten einer ToF-Kamera

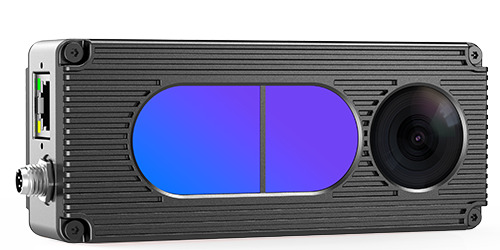

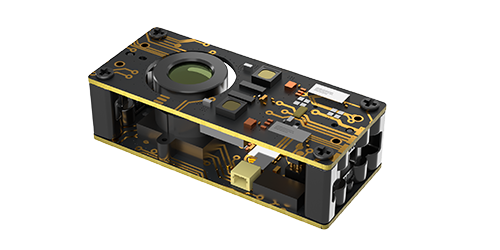

3D-ToF-Kamera bezieht sich auf das optische System als Akzeptanzpfad der nicht scannenden 3D-Bildgebungs-Tiefeninformationserfassungstechnologie. Durch die folgende Abbildung können wir verstehen, dass die ToF-Tiefenkamera aus einer Bestrahlungseinheit, einer optischen Linse, einem Bildsensor, einer Steuereinheit und einer Computereinheit besteht.

- Belichtungseinheit

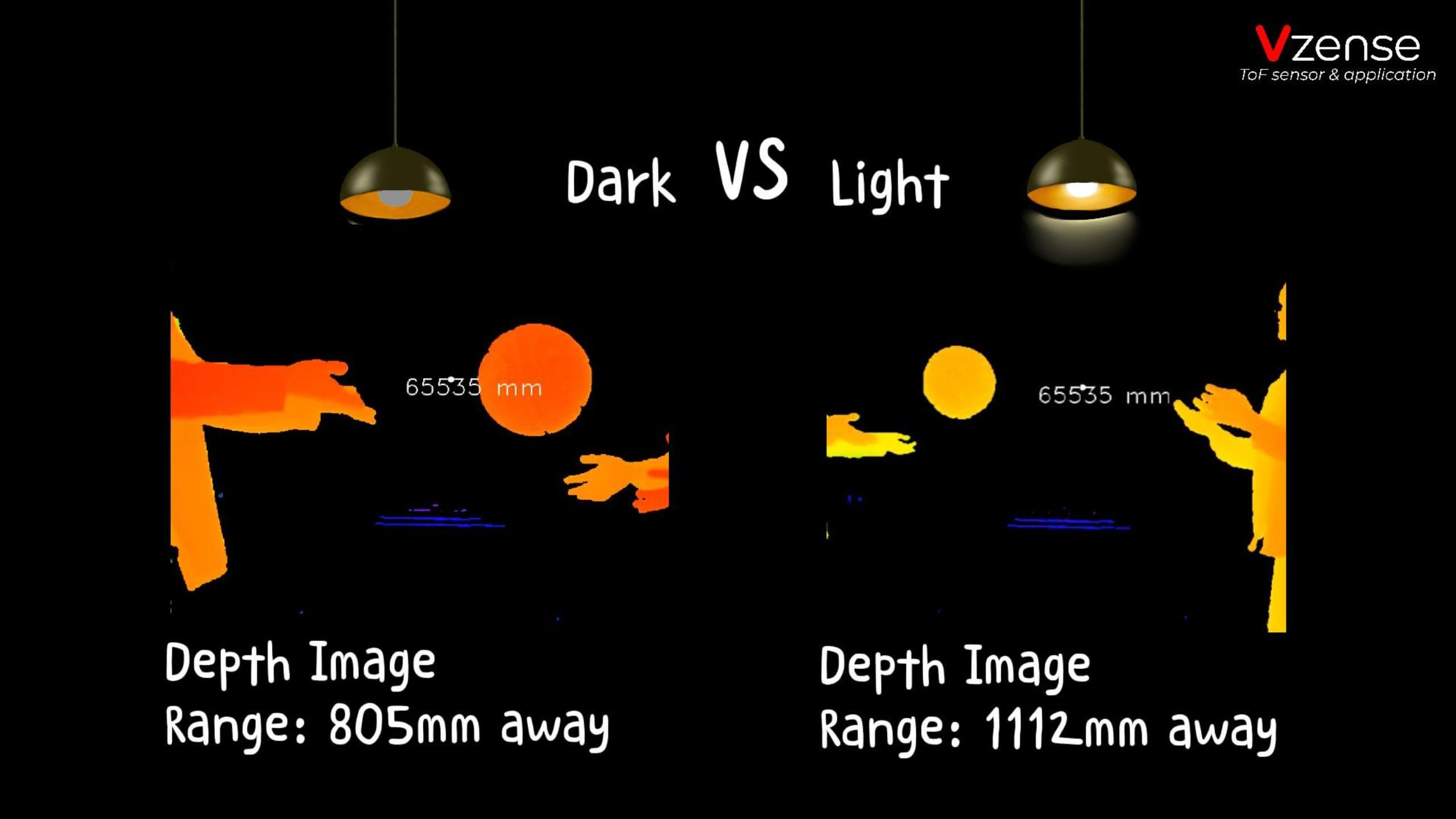

Die Belichtungseinheit muss die Lichtquelle pulsmodulieren, bevor sie emittiert wird, und die modulierte Lichtpulsfrequenz kann bis zu 100 MHz betragen. Dadurch schaltet sich die Lichtquelle während der Bildaufnahme tausendfach ein und aus, und jeder Lichtimpuls ist nur wenige Nanosekunden lang. Der Belichtungszeitparameter der Kamera bestimmt die Anzahl der Impulse pro Bild.

Um genaue Messungen zu erzielen, müssen Lichtpulse präzise gesteuert werden, so dass sie genau die gleiche Dauer, Anstiegszeit und Abfallzeit haben. Denn schon eine kleine Abweichung von nur 1 ns kann einen Abstandsmessfehler von bis zu 15 cm erzeugen. Solch hohe Modulationsfrequenzen und Genauigkeit können nur mit hochentwickelten LED- oder Laserdioden erreicht werden.

Im Allgemeinen ist die Bestrahlungslichtquelle eine Infrarotlichtquelle, die für das menschliche Auge unsichtbar ist.

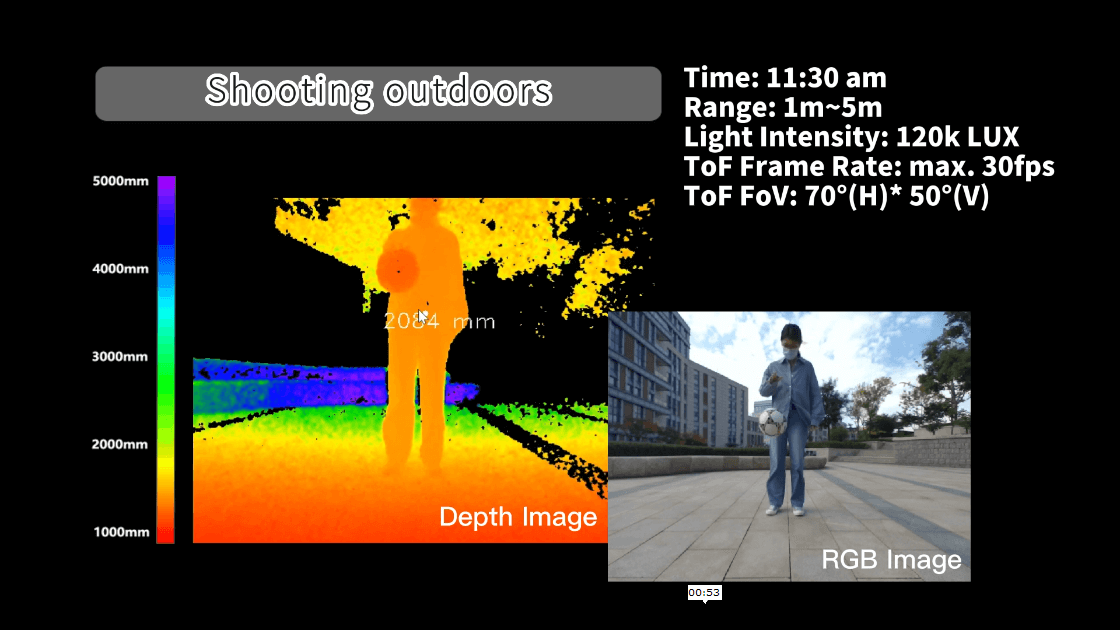

- Optische Linse

Es wird verwendet, um reflektiertes Licht und Bilder auf dem optischen Sensor zu sammeln. Im Gegensatz zu gewöhnlichen optischen Linsen ist ein Bandpassfilter erforderlich, um sicherzustellen, dass nur Licht mit der gleichen Wellenlänge wie die Beleuchtungslichtquelle eindringen kann. Zweck ist es, die inkohärente Lichtquelle zu unterdrücken, um Rauschen zu reduzieren und die Überbelichtung des Lichtsensors aufgrund der Interferenz von externem Licht zu verhindern.

- Bildgebender Sensor

Der bildgebende Sensor ist das Herzstück der TOF-Kamera. Der Aufbau dieses Sensors ähnelt dem eines gewöhnlichen Bildsensors, ist aber komplexer als der eines Bildsensors. Er enthält zwei oder mehr Verschlüsse, um reflektiertes Licht zu unterschiedlichen Zeiten zu erfassen. Daher ist die Pixelgröße des TOF-Chips viel größer als die gewöhnlicher Bildsensoren, im Allgemeinen etwa 100um.

- Steuergerät

Die von der elektronischen Steuerung der Kamera ausgelöste Lichtpulssequenz wird exakt mit dem Öffnen/Schließen des elektronischen Verschlusses des Chips synchronisiert. Er liest und wandelt Sensorladungen um und leitet sie an die Analyseeinheit und Datenschnittstelle weiter.

- Computereinheit

Die Computereinheit kann ein genaues Tiefenbild aufzeichnen. Tiefenbilder sind in der Regel Graustufenbilder, wobei jeder Wert den Abstand zwischen der lichtreflektierenden Oberfläche und der Kamera darstellt. Für bessere Ergebnisse wird in der Regel eine Datenkalibrierung durchgeführt.

Direct ToF vs Indirect ToF

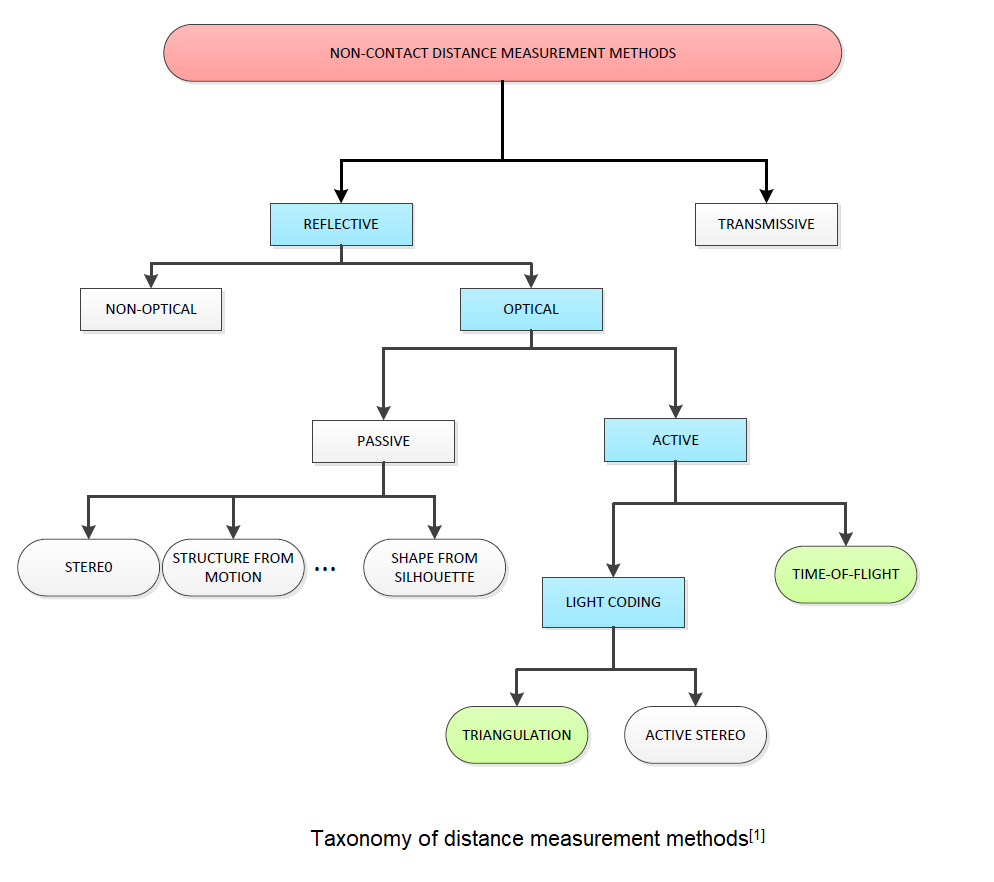

Die ToF 3D-Kameratechnologie kann je nach Implementierungsmethode in iToF (indirect ToF) und dToF (direct ToF) unterteilt werden. IToF wird weiter unterteilt in kontinuierliche Wellenform ToF und pulsbasierte ToF, wie in der folgenden Abbildung gezeigt:

dToF

DToF (Direct Time-of-Flight), welches ein direktes Time-of-Flight Verfahren zur Abstandsmessung ist, misst direkt die Zeitdifferenz zwischen der Zeit tstart, wenn der Laserpuls vom Sender gesendet wird, und der Zeit tstop, wenn der Laserpuls zum Empfänger zurückkehrt, nachdem er von einem Objekt mittels eines internen Timers reflektiert wurde. In Kombination mit der Lichtgeschwindigkeit c werden die Abstandstiefendaten d erhalten. Verglichen mit dem unten genannten Verfahren, das indirekt die Zeitdifferenz zwischen dem Sendesignal und dem Empfangssignal durch die Signalphasendifferenz misst, ist diese Methode der Messung der Zeitdifferenz direkter und wird daher als ein Direct Time-of-Flight Verfahren zur Abstandsmessung bezeichnet.

Das Prinzip des Direct Time-of-Flight Verfahrens zur Abstandsmessung ist direkt und einfach, aber auf technischer Ebene stellt es hohe Anforderungen an die Lichtquelle am Sender, den Bildsensor am Empfänger und die Schaltungen im Zusammenhang mit Synchronisation und Zeiterfassung. Zum Beispiel gibt es bestimmte Anforderungen an den Sender, um solche kurzen Impulse zu erzeugen, und der Bildsensor am Empfänger muss auch hochempfindliche optische Detektionstechnologie verwenden, um schwache optische Signale zu erkennen, wie die Einzelphotonen-Lawinendiode (SPAD)-Technologie.

The principle of direct time-of-flight ranging is direct and simple, but the technical level has high requirements for the light source at the transmitter, the image sensor at the receiver, and the circuits related to synchronization and time detection. For example, there are certain requirements for the transmitter to generate such short pulses, and the image sensor at the receiver also needs to use highly sensitive optical detection technology to detect weak optical signals, such as single photon avalanche diode (SPAD) technology.

CW ToF

Das Grundprinzip der CW iToF besteht darin: das Licht ist in eine feste Frequenz f Sinuswelle einzustellen, der Sender sendet eine Sinuswelle entsprechend der Frequenz f aus, in der Sammlung der zurückgegebenen Lichtenergie öffnet CW iToF mehrere Fenster, die von mehreren Fenstern gesammelten Daten werden abgetastet, die Phasendifferenzinformationen zwischen Emission und Empfang in einem Zyklus werden analysiert und die Entfernungsinformationen können dann durch die folgende Formel erhalten werden.

>>> Klicken Sie hier, um CW ToF-Produkte

Die meisten CW ToF-Systeme verwenden CMOS-Sensoren, insbesondere die rückbeleuchtete CMOS-Prozesstechnologie verbessert den lichtempfindlichen Bereich erheblich, verbessert die Photonensammelrate und die Geschwindigkeit der Abstandsmessung, und die Reaktionszeit kann das ns-Niveau erreichen; Um eine Phasenentwirrung zu erreichen, wendet CW ToF mehrere Modulationsfrequenzen an – ein Ansatz, der bei der Reduzierung von Mehrwegefehlern hilfreich sein kann. CW iToF ist ein vollständiges CMOS-Bildgebungssystem mit besserer Elastizität und schnellerer Auslesegeschwindigkeit, aber das CW iToF-Verfahren hat auch einige Nachteile. Sein Bildsensor erfordert vier Abtastwerte der relevanten Funktion bei mehreren Modulationsfrequenzen sowie Multiframe-Verarbeitung, so dass die Komplexität der Signalverarbeitung höher wird und zusätzliche Anwendungsprozessoren erfordern kann; Bei Messungen über größere Entfernungen oder wenn das Umgebungslicht in der Szene stärker ist, sind die Anforderungen an die kontinuierliche Ausgangsleistung relativ hoch, was sich auf die Wärmeentwicklung und -stabilität auswirkt.

Pulse ToF

Die folgende Abbildung zeigt das Prinzip von Pulse iTOF: das Licht wird in eine Rechteckwelle der festen Frequenz f eingestellt, der Sender sendet das Impulssignal entsprechend der Frequenz f, der Sensor des Empfängers besteht aus zwei elektronischen Verschlüssen (s1, s2), und die Frequenz und Phase des S1-Fensters stimmen mit dem gesendeten Impuls überein, wenn die Fenster S1 und S2 geöffnet werden (hoher Pegel), die vom Objekt reflektierten Photonen in ihrer jeweiligen Zeit akkumuliert werden und die Signalphase durch Berechnung des Verhältnisses verschiedener Energiewerte von s1 und s2 aufgelöst wird. Die Zeitdifferenz zwischen dem gesendeten Signal und dem empfangenen Signal wird berechnet, um die Entfernungsdaten zu erhalten.

Im Vergleich zum CW-iToF-Dauerstrich-Debugging bietet Pulse iToF eine einfachere Lösungstiefe, geringere Berechnungen und geringere Anforderungen an die Plattform-Backend-Verarbeitungsleistung. Nach dem Prinzip von Pulse iTOF emittiert Pulse iTOF hochintensive Lichtimpulse in einem kurzen Zeitfenster, die den Einfluss von Hintergrundlichtsignalen reduzieren, es anpassungsfähiger an Änderungen des Umgebungslichts machen und Problemen wie der Bewegungsunschärfe von Szenen besser widerstehen können.

>>> Klicken Sie hier, um Pulse ToF-Produkte

Unterschiedlicher Technologievergleich

| Stereo | Speckle Structured Light | Striped Structured Light | iTOF | dTOF | LiDar | |

|---|---|---|---|---|---|---|

| Accuracy | High at near place | High at near place | High | Linear with distance | Fixed error | Sub-millimeter |

Detection distance | Near | Near | Near | Medium near | Medium far | Medium far |

| FoV | Medium | Medium | Medium | Big | Big | Low |

| Frame rate | High | Medium | Low | High | Medium | Medium |

| Resolution | Medium | Medium | High | Medium | Medium | Low |

| Cost | Low | Medium | High | Medium | High | High |

Light influence | Low | High | High | Low | Low | Low |

Die Vorteile der ToF-Technologie manifestieren sich in mehreren Dimensionen, einschließlich Erfassungsabstand, Winkel, Bildrate, Lichtbeständigkeit, Kosteneffizienz usw.; In Szenarien, in denen die Genauigkeit über dem mm-Bereich liegen, bietet die ToF-Technologie einen relativ großen Vorteil.

Anwendungsgebiete

Automatisierungsanwendungen

AGV

AGV

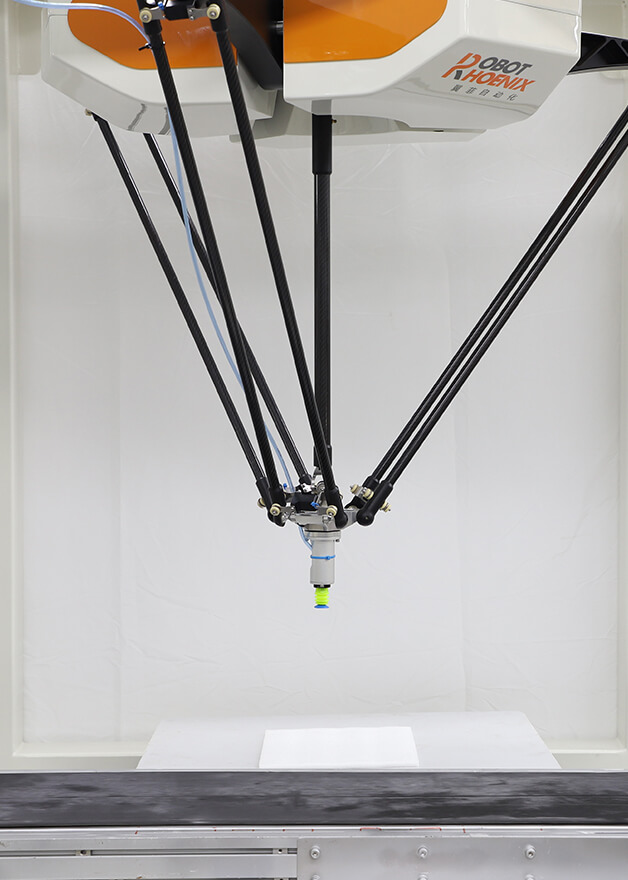

Visual Control for Delta Robot

Visual Control for Delta Robot

Smart Agriculture

Smart Agriculture

Dimension Measurement

Dimension Measurement

Palletizing and Depalletizing

Palletizing and Depalletizing

Erfassung menschlicher Posen

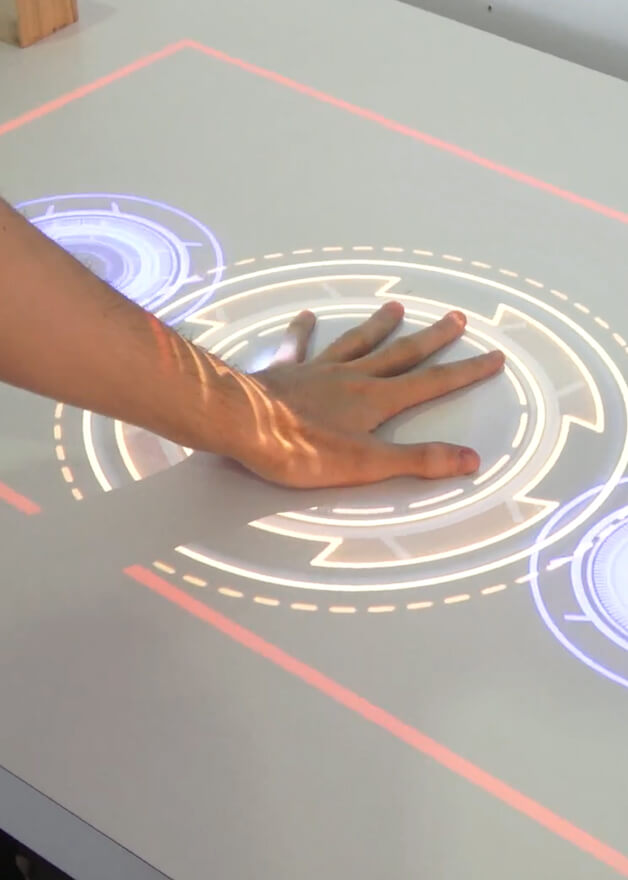

Interaction

Interaction

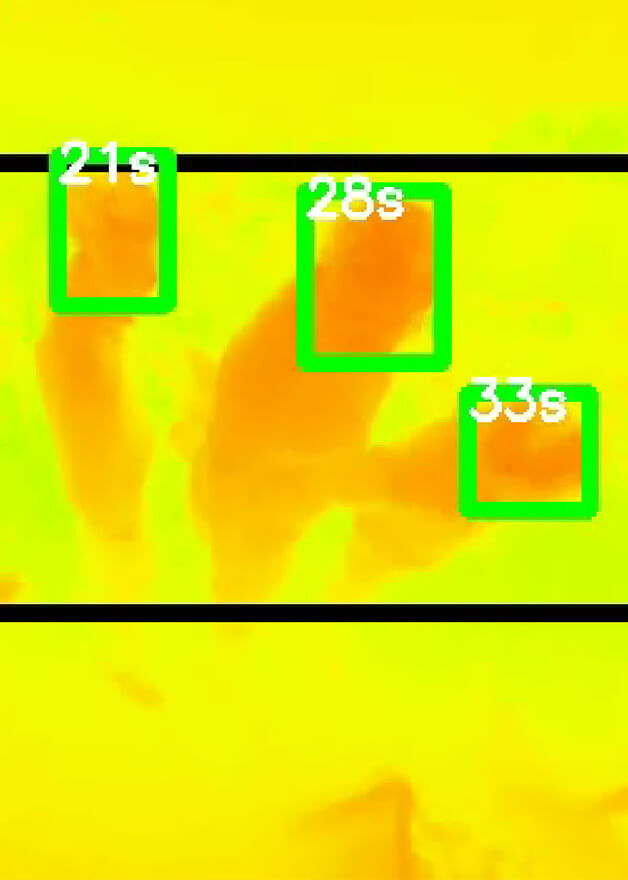

Fall Detection

Fall Detection

Automated Fare Collection

Automated Fare Collection

People Counting

People Counting

Videos

Branchen

Leistungsdemonstration

DE

DE

.jpg)

.png)

.png)

.png)

.png)